Die Google Search Console (GSC) ist ein unverzichtbares Tool für Website-Betreiber und SEO-Profis. Sie bietet zahlreiche Funktionen, mit denen Ihr eure Website analysieren und verbessern könnt. Doch welche Funktionen bietet die GSC eigentlich und welche Vorteile hat sie noch? In diesem Beitrag erfahrt Ihr alles Wichtige über die Google Search Console, wie Ihr sie einrichten könnt und wie sie Euch in eurem SEO-Alltag unterstützen kann.

- Was ist die Google Search Console?

- Welche Funktionen bietet die GSC?

- Google Search Console einrichten (Schritt-für-Schritt)

- Das Google Search Console Dashboard

- Leistungsbericht: Suchanfragen und Seiten-Performance analysieren

- URL-Prüfung: Einzelne Seiten untersuchen und Indexierung anstoßen

- Indexierungsbericht: Index-Status und Crawling-Probleme im Blick

- Sitemaps: Inhalte gezielt an Google übermitteln

- Core Web Vitals: Ladezeiten und Nutzererlebnis optimieren

- Sicherheitsprobleme & Manuelle Maßnahmen: Warnungen ernst nehmen

- Weitere wichtige Berichte und Funktionen

- Best Practices für deinen SEO-Alltag: Wie du die Search Console effektiv nutzt

- Bonus-Tipp: Die Google Search Console und der Screaming Frog

- Fazit: Unverzichtbar für nachhaltiges SEO

Was ist die Google Search Console?

Die Google Search Console (GSC) ist ein kostenloses Tool von Google, mit dem du die Präsenz deiner Website in den Google-Suchergebnissen beobachten und optimieren kannst. Sie liefert detaillierte Daten zur Leistung deiner Website (z.B. Klicks, Impressionen und durchschnittliche Position), zeigt dir mit welchen Suchanfragen Nutzer deine Seite finden und warnt dich vor technischen Problemen, Sicherheitsvorfällen oder Indexierungsfehlern.

Kurz gesagt: Ob SEO-Anfänger oder Profi – die GSC ist ein unverzichtbares Werkzeug, um die Sichtbarkeit deiner Website in der Google-Suche zu analysieren und gezielt zu verbessern. Zudem erhältst du bei neuen Problemen automatische E-Mail-Benachrichtigungen, damit du sofort reagieren kannst. In diesem Leitfaden erfährst du Schritt für Schritt, wie du die Search Console einrichtest, welche wichtigen Berichte und Funktionen sie bietet und wie du sie als SEO-Einsteiger effektiv nutzt, um deine Rankings zu verbessern und mehr Besucher zu gewinnen.

Welche Funktionen bietet die GSC?

Die Google Search Console umfasst eine Reihe von Berichten und Funktionen, die für die Website-Optimierung unerlässlich sind. Hier ein kurzer Überblick der wichtigsten Funktionen und was Du damit machen kannst:

- Performance/Leistungsbericht (Suchanalyse): Zeigt Dir, wie Deine Website in der Google-Suche performt – mit Kennzahlen wie Klicks, Impressionen, Click-Through-Rate (CTR) und durchschnittliche Position für Suchanfragen. Du kannst analysieren, welche Keywords und Seiten Traffic bringen und wo Potential für Verbesserungen besteht.

- Indexierungs- bzw. Abdeckungsbericht: Informiert Dich darüber, welche Seiten Deiner Website indexiert wurden und welche nicht. Hier erkennst Du Indexierungsprobleme (z.B. Seiten mit Fehlern, ausgeschlossene URLs) und kannst deren Ursachen einsehen.

- URL-Prüftool (URL Inspection): Ermöglicht die Analyse einzelner URLs Deiner Website. Du erfährst, ob eine bestimmte Seite im Google-Index ist, wann sie zuletzt gecrawlt wurde und ob Indexierungsprobleme vorliegen. Außerdem kannst Du damit eine Live-Abfrage durchführen und ggf. die Indexierung neu anstoßen.

- Sitemaps-Verwaltung: Hier kannst Du Deine XML-Sitemaps einreichen und den Status einsehen. Eine Sitemap ist eine XML-Datei, die alle wichtigen Seiten auflistet – so findet Google Deine Inhalte schneller. Die Search Console zeigt, ob die Sitemap erfolgreich abgerufen wurde und wie viele URLs daraus indexiert wurden.

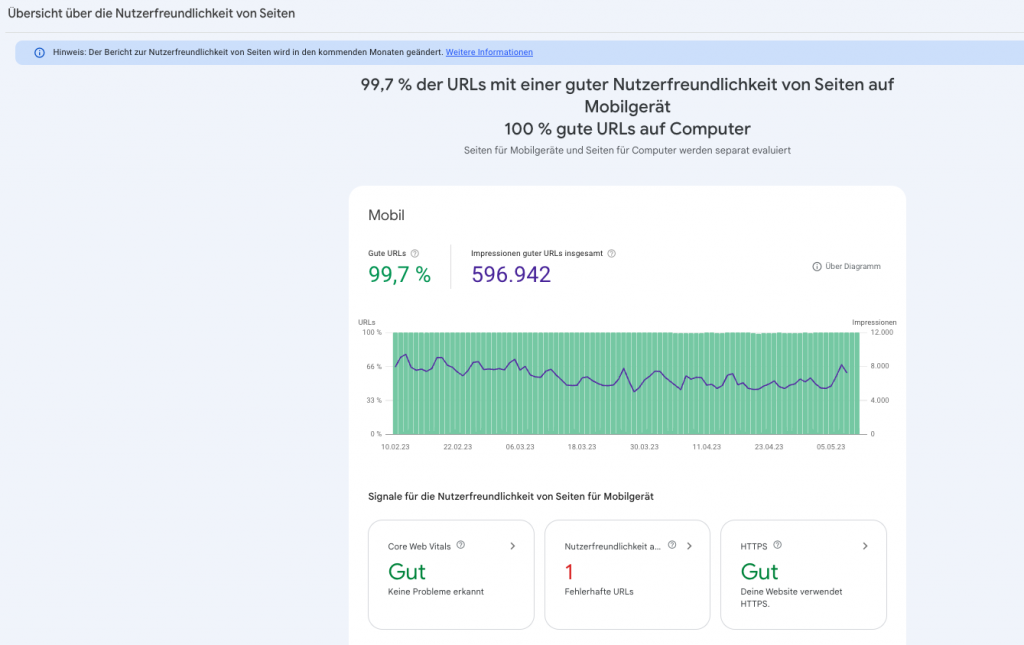

- Nutzerfreundlichkeit (Mobile Usability): Dieser Bericht zeigt Usability-Probleme auf Mobilgeräten auf. Dazu zählen z.B. zu kleine Texte, nicht an den Bildschirm angepasste Ansichten oder zu dicht beieinander liegende klickbare Elemente. Mobile Nutzerfreundlichkeit ist ein Rankingfaktor, daher solltest Du diese Fehler beheben.

- Core Web Vitals (Seiten-Erlebnis): Die GSC liefert Daten zu Ladezeiten und Stabilität Deiner Seiten (Largest Contentful Paint, Cumulative Layout Shift etc.), basierend auf echten Nutzerdaten. Diese Metriken fließen in das Seiten-Erlebnis ein und sind für SEO relevant. (Für Anfänger zunächst weniger zentral, aber gut zu wissen.)

Die GSC bietet noch weitere Vorteile, die oft übersehen werden. Dazu gehören:

- kostenfreie Nutzung

- mögliche Verknüpfung mit Google Analytics und anderen Google-Diensten (und damit eine weitere Verarbeitung der Daten in Reportings)

- Sicherheit: Die GSC warnt Euch, wenn Eure Website von Hackern angegriffen wird oder wenn Malware auf Eurer Website gefunden wurde.

- Backlinks: Ihr könnt sehen, welche Websites auf Eure Website verlinken und wie viele Backlinks ihr habt haben.

- strukturierte Daten: Strukturierte Daten können Google bei dem Verständnis der eigenen Seite helfen und Produkteigenschaften (wie Preis, Verfügbarkeit oder Bewertungen) oder Öffnungszeiten und Adressen auszeichnen. In der Google Search Console kann überprüft werden, ob diese auch korrekt implementiert sind und ausgelesen werden können.

Zusammenfassend bietet die Google Search Console zahlreiche Funktionen und Vorteile, um die Leistung Eurer Website in den Suchergebnissen zu verbessern. Sie ist einfach einzurichten und zu verwenden und bietet wertvolle Einblicke in den Organic Search Traffic auf Eurer Website. Wenn Ihr also eine Webseite betreibt, ist die GSC ein unverzichtbares Tool in Eurem SEO-Arsenal.

Google Search Console einrichten (Schritt-für-Schritt)

Um die Google Search Console einzurichten, müsst Ihr zuerst ein Google-Konto haben. Wenn Ihr bereits ein Konto habt, loggt Euch einfach ein. Wenn nicht, solltet Ihr euch schnell ein Google-Konto anlegen. Sobald Ihr eingeloggt seid, geht Ihr zur GSC-Website (https://search.google.com/search-console/about) und klickt auf die Schaltfläche „Registrieren“.

Jetzt tragt Ihr die URL eurer Webseite ein und bestätigt diese.

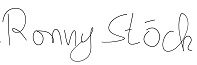

Dabei habt Ihr die Möglichkeit, eine komplette Domain (Domain Property) oder einzelne Verzeichnisse (URL-Präfix Property) anzulegen. Beide Verfahren haben ihre Vor- und Nachteile.

Bei kleineren Seiten ist die Property auf Domainebene die empfohlene Methode, da Ihr Euch so viel Zeit und Arbeit spart. Eine URL Präfix-Property bietet sich besonders bei großen Domains an, da ihr bei den Auswertungen immer nur 1.000 URLs angezeigt bekommt.

Wenn Ihr also bspw. einen großen Onlineshop habt, dann könntet ihr für eure einzelnen Kategorien jeweils eine eigene Property anlegen, und anschließend alle Artikel auch entsprechend auswerten (sofern es nicht mehr 1.000 Artikel pro Kategorie sind). Ihr könnt auch jederzeit beide Möglichkeiten parallel nutzen, also gerne zum Start erst einmal die Domain-Property aufsetzen.

Kurz zusammengefasst:

Domain-Property: Deckt alle Subdomains und Protokolle Deiner Domain ab (z.B. http://, https://, www. und ohne www). Hier ist als Verifizierung ein DNS-Eintrag erforderlich.

URL-Präfix-Property: Gilt nur für eine spezifische URL und deren Unterseiten (z.B. https://www.deinedomain.de/). Diese kann auf verschiedene Arten verifiziert werden.

Für Anfänger ist die Domain-Property oft sinnvoller, da Du damit alles auf einmal abdeckst – allerdings musst Du dafür Zugriff auf die DNS-Einstellungen Deiner Domain haben.

Damit Google Eure Website überprüfen kann, müsst Ihr eine der folgenden Methoden auswählen, um die Inhaberschaft der Webseite zu bestätigen:

- HTML-Datei-Upload: Google gibt Dir eine spezielle HTML-Datei, die Du im Stammverzeichnis Deiner Website hochlädst.

- HTML-Tag: Du fügst einen von Google bereitgestellten <meta>-Tag in den <head>-Bereich der Startseite ein.

- DNS-Eintrag: Du erstellst einen bestimmten TXT-Eintrag bei Deinem Domain-Provider (notwendig für Domain-Property).

- Google Analytics oder Google Tag Manager: Wenn auf der Website bereits Google Analytics oder der Tag Manager eingebunden ist, kannst Du darüber verifizieren.

- Wähle die Methode, die Dir am besten passt. Viele Einsteiger nutzen den HTML-Tag oder den Analytics-Weg, da dies relativ unkompliziert ist. Früher musste man häufig eine Datei hochladen oder Code-Snippets einbinden, heute geht es oft auch „komfortabel“ über bestehende Google-Integrationen. Wichtig ist: Sobald Du eine Methode erfolgreich umgesetzt hast, klicke auf „Bestätigen“ – die Search Console prüft dann die Präsenz des Tags/Files/DNS-Eintrags

Wählt einfach die Methode, die für Euch am einfachsten ist, und folgt den Anweisungen.

Fertig ist die Einrichtung der Google Search Console!

Nachdem Ihr die Inhaberschaft bestätigt habt, könnt Ihr auf die Daten der GSC zugreifen. Hier ist von Bedeutung, dass erst Daten ab dem Moment der Bestätigung gesammelt und eingesehen werden können.

Nachdem deine Website verifiziert ist, solltest du eine XML-Sitemap hinzufügen. Eine Sitemap ist eine Datei im XML-Format, die Google eine hierarchisch strukturierte Übersicht aller Seiten deiner Website bietet. Über die GSC kannst du deine Sitemap unter „Sitemaps“ einreichen, damit Google alle wichtigen Inhalte deiner Website schneller findet und indexiert. Idealerweise wird die Sitemap von deinem CMS oder SEO-Plugin automatisch erstellt und aktuell gehalten. Füge die URL der Sitemap (oft deinedomain.de/sitemap.xml) im GSC-Sitemaps-Tool hinzu und klicke auf „Senden“.

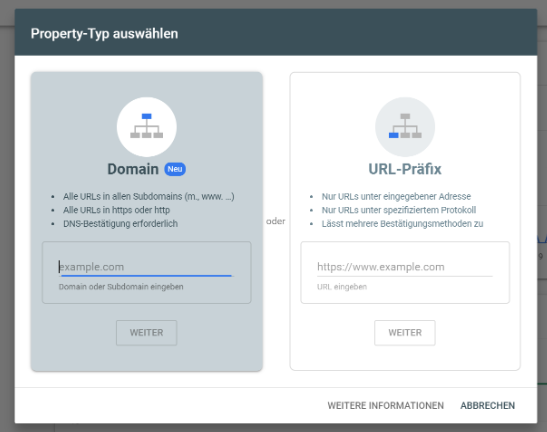

Das Google Search Console Dashboard

Wenn Du die GSC das erste Mal aufrufst (und Deine Property ausgewählt hast), landest Du auf der Übersichtsseite – dem Dashboard. Hier bekommst Du einen Schnellüberblick über die Performance und den Indexierungsstatus Deiner Website. In der Regel siehst Du an prominentester Stelle eine Grafik mit den Gesamt-Klicks der letzten 3 Monate (Standardzeitraum). Darunter können weitere Karten erscheinen, etwa zum Indexierungsstatus (wie viele Seiten gültig indexiert sind vs. Fehler/ausgeschlossen) oder zu Experience/Seitenerlebnis (z.B. Core Web Vitals Zusammenfassung) – abhängig davon, welche Daten bereits vorliegen. Das Dashboard dient also als gesundheitlicher Überblick Deiner Website: Du erkennst sofort, ob es irgendwo rote Fehlermeldungen gibt (z.B. Indexierungsfehler) oder ob die Klickkurve auffällig nach oben oder unten zeigt.

Neben den Kennzahlen bietet das Dashboard auch die Navigationsstruktur. Links findest Du das Menü mit den Hauptsektionen: Leistung, Indexierung, Nutzerfreundlichkeit (bzw. Seiten-Erfahrung), Sicherheit & manuelle Maßnahmen, Links usw. Über diese Menüpunkte gelangst Du in die detaillierten Berichte. Oben auf der Übersichtsseite gibt es zudem ein Suchfeld „URL prüfen“, mit dem Du direkt eine konkrete URL Deiner Website inspizieren kannst. Vom Dashboard aus kannst Du also überall hin navigieren: entweder per Klick auf die jeweilige Karte („Zum Bericht“) oder über das linke Menü.

Ein weiterer Bereich, den es zu beachten gilt, sind die Mitteilungen: In der rechten oberen Ecke (Glockensymbol) informiert Dich GSC über wichtige Ereignisse. Beispielsweise erhältst Du hier Benachrichtigungen, wenn neue Abdeckungsprobleme entdeckt wurden oder wenn verbesserungswürdige Core Web Vitals gemeldet werden. Diese solltest Du im Auge behalten. Alles in allem ist das Dashboard aber vor allem dein Startpunkt, um schnell zu sehen, ob Handlungsbedarf besteht, und von dort in die einzelnen Berichte abzutauchen.

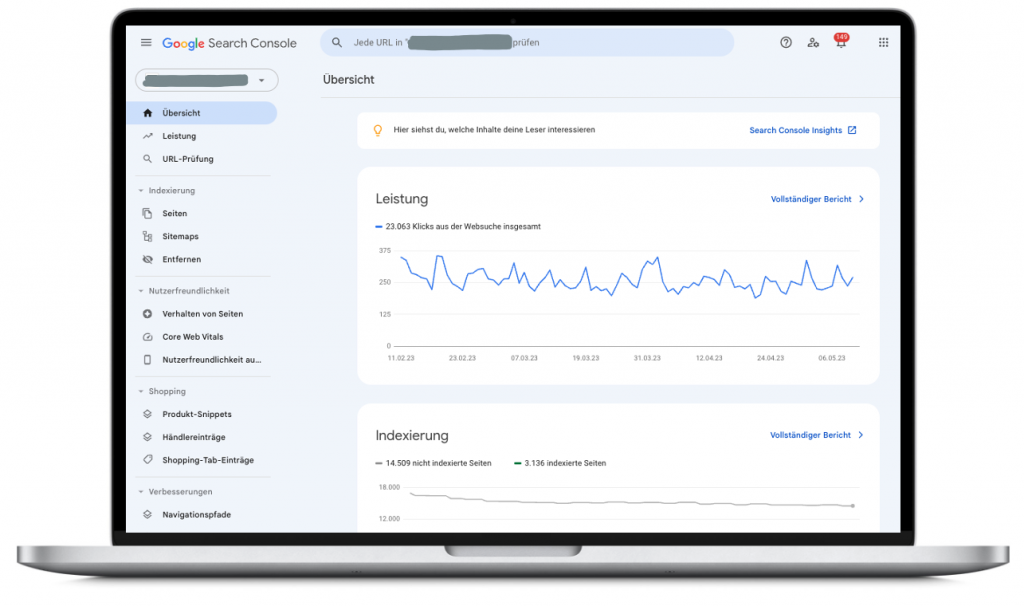

Leistungsbericht: Suchanfragen und Seiten-Performance analysieren

Der Leistungsbericht ist das Herzstück der Google Search Console. Hier erfährst du im Detail, wie deine Website in den Google-Suchergebnissen performt – von der Anzahl der Klicks und Impressionen bis zur Click-Through-Rate (CTR) und durchschnittlichen Position deiner Seiten und Keywords. Besonders praktisch: Diese Daten lassen sich vielfältig filtern und segmentieren, z.B. nach Zeitraum (bis zu 16 Monate rückwirkend), nach Gerätetyp (Desktop oder Mobil), nach Land oder sogar nach Seitentyp. Du kannst also gezielt Fragen untersuchen wie „Wie ranken meine Produktseiten in der mobilen Suche in Deutschland?“ – ein paar Filter genügen, um die Antwort zu erhalten.

Für Einsteiger: Der Leistungsbericht bietet einen hervorragenden Einstieg, um die wichtigsten SEO-Kennzahlen deiner Website kennenzulernen. Du kannst etwa sehen, für welche Suchanfragen (Keywords) deine Website am häufigsten angezeigt wird und welche Seiten die meisten Klicks erhalten. Über Tabs wie „Suchanfragen“ und „Seiten“ kannst du die Top-1000 Keywords und URLs einsehen und nach Klicks, Impressionen oder CTR sortieren. So erkennst du schnell, welche Inhalte gut performen und wo noch Potenzial besteht. Beobachte zum Beispiel Seiten mit niedriger CTR: Wenn viele Nutzer die Seite in den Suchergebnissen sehen, aber selten klicken, solltest du Titel und Snippet optimieren, damit sie den Inhalt besser widerspiegeln und attraktiver werden. Schon kleine Anpassungen können die Klickrate spürbar steigern – was wiederum mehr Besucher bedeutet.

Für Fortgeschrittene: Erfahrene SEO-Profis nutzen den Leistungsbericht, um Trends zu analysieren und gezielte Optimierungen abzuleiten. Dank des 16-Monate-Datenspeichers können etwa Saisonverläufe und Jahresvergleiche erstellt werden. Ein beliebter Profi-Tipp ist die Jagd auf „Low Hanging Fruits“: Dabei filterst du die Suchanfragen nach Positionen größer 10 (Seite 2 der Suchergebnisse) und sortierst nach Impressionen. Die so gefundenen Keywords ranken knapp außerhalb der Top 10, haben aber viele Sichtkontakte. Durch gezielten Feinschliff am Content oder den Meta-Tags lässt sich hier oft der Sprung auf Seite 1 schaffen – was in der Regel deutlich mehr Klicks und Traffic bedeutet. Über die Vergleichsfunktion kannst du außerdem Zeiträume (z.B. Vorher/Nachher einer SEO-Maßnahme) oder verschiedene Suchtypen vergleichen und so den Erfolg von Optimierungen nachvollziehen.

Praxis-Tipps für den Leistungsbericht:

– Starke und schwache Keywords identifizieren: Schaue Dir den Tab Suchanfragen an. Sortiere z.B. nach Impressionen, um Keywords zu finden, bei denen Deine Seite oft angezeigt wird, aber vielleicht noch wenige Klicks bekommt (hohe Impressionen, niedrige CTR). Diese Begriffe haben Potential: Eventuell rankst Du hier noch auf Seite 2 oder 3 und könntest durch Optimierungen (bessere Inhalte, mehr interne Links) in die Top 10 kommen.

– CTR-Verbesserung: Sortiere nach CTR oder vergleiche Klicks vs. Impressionen. Findest Du Keywords mit sehr niedriger CTR (z.B. < 2%), obwohl Du auf Seite 1 rankst? Dann könnte Dein Snippet (Title/Description) unattraktiv sein. Beispiel: Angenommen, Deine Seite erscheint für „Vegane Rezepte“ auf Position 5 und hatte 10.000 Impressionen, aber nur 100 Klicks (CTR 1%). Das ist eher niedrig. Hier könntest Du versuchen, den Seitentitel und die Meta-Description klickfreundlicher zu formulieren – etwa indem Du Besonderheiten hervorhebst („Über 50 leckere vegane Rezepte – schnell & einfach“). Durch solche Optimierungen lässt sich die Klickrate oft deutlich steigern, was zu mehr Besuchern führt, ohne dass Du Deinen Rankingplatz verändern musst.

– Ranking-Veränderungen überwachen: Nutze die Datumsfilter, um Zeiträume zu vergleichen. Wenn ein wichtiges Keyword deutlich an Klicks verliert, kannst Du einen Vergleich „letzte 3 Monate“ vs. „vorherige 3 Monate“ durchführen. Vielleicht siehst Du, dass die Position von durchschnittlich 3 auf 8 gefallen ist, oder die Impressionen stark zurückgegangen sind – ein Indiz, dass Dein Ranking gefallen ist oder das Suchvolumen nachgelassen hat. Im Leistungsbericht kannst Du so Abwärtstrends frühzeitig erkennen. Praxisbeispiel: Du stellst fest, dass die Seite für das Keyword “Schuhe kaufen” im aktuellen Monat 30% weniger Klicks hat als im Vormonat. Ein Blick in die GSC-Daten mit einem Zeitraumvergleich zeigt, dass die durchschnittliche Position von 5 auf 9 abgerutscht ist. Nun weißt Du, dass Du hier gegensteuern musst – z.B. Inhalte aktualisieren, Konkurrenten analysieren oder zusätzliche Backlinks aufbauen – um das Ranking wieder zu verbessern.

– Weitere Berichte nutzen: Beachte, dass es im Bereich Leistung auch Unterberichte wie Discover und Google News gibt (falls Deine Seite dort auftaucht). Als Anfänger ist der Fokus aber klar auf den Suchergebnisse-Bericht zu legen.

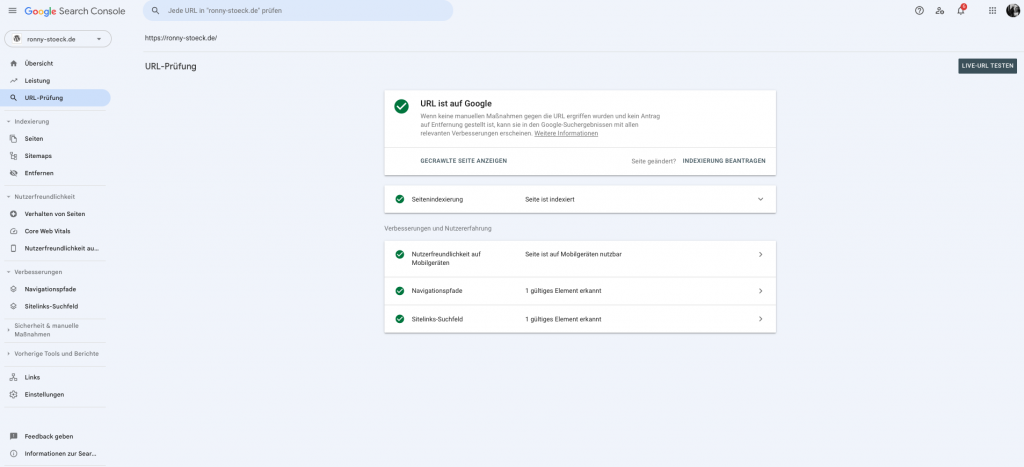

URL-Prüfung: Einzelne Seiten untersuchen und Indexierung anstoßen

Mit dem URL-Prüftool hast du einen direkten Draht zu Google für jede einzelne Seite deiner Website. Gib eine vollständige URL ein, und du erhältst detaillierte Infos darüber, was Google über diese Seite weiß. Du siehst zum Beispiel, ob die URL indexiert ist, wann Google sie zuletzt gecrawlt hat und ob beim Crawling oder Rendern Fehler auftraten. Außerdem kannst du eine Live-Abfrage starten, bei der Google die Seite in Echtzeit prüft.

Hauptfunktionen des URL-Prüftools:

- Indexierungsstatus abrufen: Zeigt, ob die Seite im Google-Index ist. Wenn nicht, wird auch begründet, warum nicht (z.B. „Von

noindexausgeschlossen“ oder „Seite wurde nicht gefunden (404)“). - Live-URL testen: Prüft die aktuelle Version der Seite so, wie Googlebot sie sieht. Das ist nützlich, um etwa zu überprüfen, ob kürzlich behobene Probleme (z.B. Mobilfreundlichkeit oder strukturierte Daten) nun gelöst sind.

- Indexierung anfordern: Mit einem Klick auf „Indexierung beantragen“ kannst du Google auffordern, die Seite zu crawlen. Gerade nach Updates, neuen Inhalten oder einem Relaunch beschleunigt dies das Auffinden durch Google enorm.

- Gerenderte Ansicht und Ressourcen: Das Tool zeigt einen Screenshot der Seite aus Googlebots Sicht und listet geladenes HTML sowie blockierte Ressourcen auf. So erkennst du Probleme wie nicht geladene Skripte, Bilder oder CSS, die evtl. durch die robots.txt gesperrt wurden. Auch kannst du sehen, ob die mobile Darstellung aus Googles Perspektive stimmt.

- Kanonische URL: Falls Google eine andere URL als kanonisch ansieht (bei Duplicate Content), wird das ebenfalls angezeigt.

Für Einsteiger: Die URL-Prüfung ist ideal, um neue oder geänderte Seiten schnell in Google zu bringen. Hast du zum Beispiel einen neuen Blogpost veröffentlicht, kannst du die URL im Tool prüfen. Siehst du den Status „URL ist nicht auf Google“, kannst du sofort die Indexierung beantragen, anstatt darauf zu warten, dass der Googlebot die Seite von selbst entdeckt. Auch wenn eine Seite in der Suche nicht auftaucht, hilft das Tool: Es zeigt an, ob eventuell Indexierungsprobleme vorliegen – etwa ein vergessener noindex-Tag oder ein Serverfehler. Für Einsteiger ist es zudem spannend zu sehen, wie Google die Seite rendert. So kann man prüfen, ob alle Inhalte für Google sichtbar sind (wichtig z.B. bei Inhalten, die per JavaScript nachgeladen werden). Ebenso bekommt man erste Hinweise zur Mobilfreundlichkeit der Seite und zu strukturierten Daten auf der Seite. Kurz gesagt: Die URL-Prüfung gibt neuen Website-Betreibern die Gewissheit, dass einzelne Seiten korrekt von Google verarbeitet werden – und ermöglicht schnelles Eingreifen, falls nicht.

Für Fortgeschrittene: Profis verwenden das URL-Inspektionstool vor allem zum Debugging einzelner SEO-Probleme. Wenn eine wichtige Seite trotz optimierten Inhalts nicht rankt, lässt sich hier checken, ob Google sie überhaupt crawlen konnte oder ob z.B. Crawl-Budget-Probleme, Duplikat-Content (Kanonisierung) oder Rendering-Issues vorliegen. Auch bei JavaScript-Seiten (Single-Page-Apps etc.) ist das Tool unverzichtbar: Man sieht den vom Googlebot gerenderten HTML-Code und erkennt, ob wesentliche Inhalte fehlen. Zudem bietet das Tool einen schnellen Weg, nach technischen Änderungen einen Recrawl anzustoßen, was im Fehlerfall sehr hilfreich ist (z.B. „Ich habe die defekte Weiterleitung korrigiert – bitte neu prüfen“). Fortgeschrittene können so die Indexierungsdiagnose auf URL-Ebene betreiben. Hinweis: Über die Search Console API lässt sich die URL-Prüfung sogar automatisiert nutzen, um z.B. viele Seiten regelmäßig zu checken – ein Thema für Entwickler, das hier nur am Rande erwähnt sei.

TIPP: Anleitung zur schnelleren Indexierung einer neuen URL:

- Gebt die neue URL oben in der Suchleiste ein

- Ihr solltet nun die Meldung angezeigt bekommen „URL ist nicht auf Google“

- Klicket nun auf „Indexierung beantragen“. Innerhalb der nächsten 24h sollte die entsprechende URL bei Google im Index erscheinen

- Überprüfen könnt ihr das mit einer site – Abfrage bei Google. Gebt dazu folgendes bei Google ein:

site:euredomain.de/zuindexierende-url

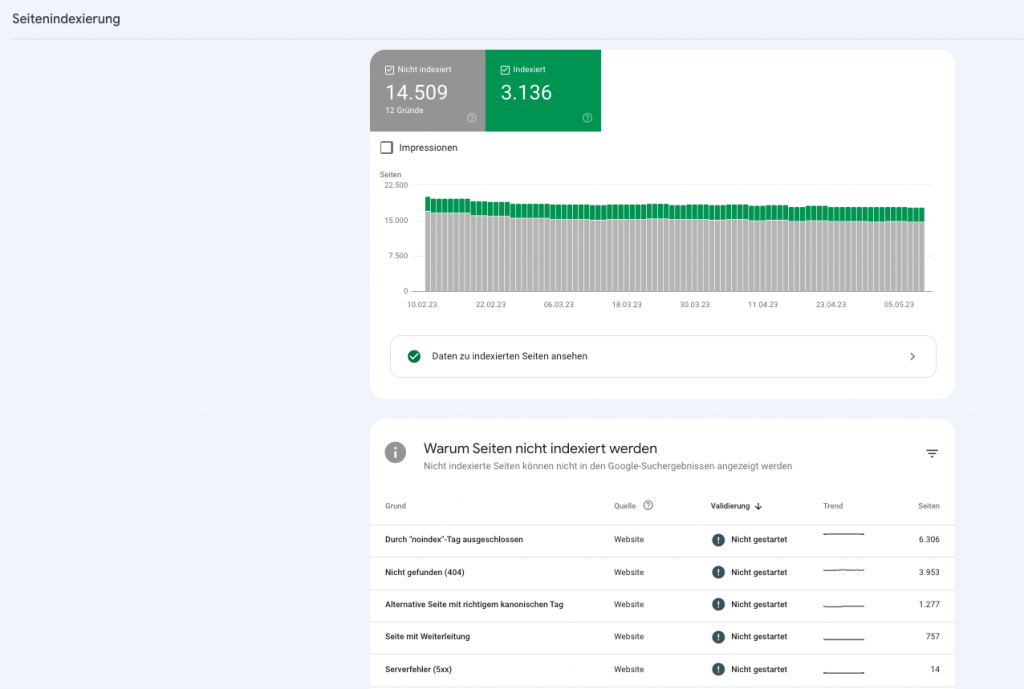

Indexierungsbericht: Index-Status und Crawling-Probleme im Blick

Unter Indexierung bietet die Search Console den Bericht „Seiten“ (früher Indexabdeckung genannt), der dir einen Überblick über den Indexierungsstatus aller URLs deiner Website liefert. Du siehst hier wie viele Seiten indexiert wurden und welche URLs nicht im Index sind, inklusive der Gründe dafür. Google kategorisiert den Status jeder URL in vier Gruppen:

- Fehler: Seite nicht indexiert aufgrund gravierender Probleme (z.B. Serverfehler oder fehlerhafte Weiterleitungen). Diese Seiten erfordern dringende Aufmerksamkeit.

- Gültig mit Warnung: Seite indexiert, aber mit potenziellen Problemen. Hier sollte geprüft werden, ob trotz Indexierung Optimierungsbedarf besteht (z.B. Indexierung mit unerwünschtem Parameter).

- Gültig: Seite erfolgreich indexiert, alles in Ordnung.

- Ausgeschlossen: Seite nicht indexiert aus bewusstem oder technischem Grund – z.B. durch ein

noindex-Tag, eine robots.txt-Sperre oder weil es sich um ein Duplikat handelt.

Ein paar häufige Statusmeldungen im Indexierungsbericht sind zum Beispiel:

- Seite mit Weiterleitung: Die URL leitet auf eine andere URL weiter (d.h. diese konkrete URL ist nicht indexiert, sondern die Ziel-URL).

- Durch „noindex“-Tag ausgeschlossen: Auf der Seite befindet sich ein <meta name=“robots“ content=“noindex“>, wodurch sie bewusst von der Indexierung ausgenommen wird.

- Alternative Seite mit kanonischem Tag: Google hat erkannt, dass diese Seite ein Duplikat einer anderen ist (Canonical URL). Die Seite selbst wird nicht indexiert, stattdessen die als kanonisch markierte.

- Nicht gefunden (404): Die URL konnte nicht gefunden werden (toter Link).

- Vom robots.txt ausgeschlossen: Deine robots.txt-Datei verbietet Googlebot, die Seite zu crawlen, daher kann sie nicht indexiert werden.

- Gecrawlte – derzeit nicht indexiert: Google konnte die Seite crawlen, hat sie aber (noch) nicht in den Index aufgenommen – oft temporär, kann später indexiert werden oder es fehlt Relevanz.

- Soft 404: Die Seite wurde geladen, aber der Inhalt sieht für Google aus wie eine Fehlerseite (z.B. „Seite nicht gefunden“ Meldung ohne echten 404-Status).

- Serverfehler (5xx): Beim Crawlversuch hat der Server einen Fehler zurückgegeben (5xx Codes wie 500).

Die obige Liste ist nicht vollständig, aber dies sind typische Beispiele. Jeder dieser Fälle erfordert eine andere Handlung: Eine Seite mit noindex brauchst Du nicht zu „fixen“, wenn sie absichtlich nicht indexiert werden soll; eine 404-Seite hingegen sollte geprüft werden – gibt es einen veralteten Link darauf? Muss sie auf eine neue URL umgeleitet werden? Der Bericht hilft Dir also, Fehlerquellen aufzudecken. Du bekommst zu jeder Problemkategorie einige Beispiel-URLs angezeigt und kannst über „Details“ auch alle betroffenen URLs exportieren. Google liefert oft auch einen kurzen Erklärungstext zum jeweiligen Status. Wichtig: Nicht jede nicht indexierte Seite ist per se ein Problem. Es ist normal, dass nicht alle URLs im Index landen – beispielsweise archivierte Seiten mit noindex, Duplicate-Content-Seiten oder Admin-Bereiche sollen ja gerade nicht indexiert werden. Du solltest Dich also vor allem auf diejenigen Nicht-Indexierungen konzentrieren, die unerwünscht sind. Ein typisches Vorgehen: Filtere im Abdeckungsbericht nach „Fehler“ – hier listet GSC meist die kritischen Dinge wie serverseitige Fehler oder wichtige Seiten, die nicht indexiert werden konnten. Diese Fehler gilt es zu priorisieren und zu beheben.

Für Einsteiger: Dieser Bericht hilft besonders dabei zu überprüfen, ob Google alle wichtigen Seiten der Website erfasst. Du erkennst sofort, wenn z.B. ein neuer Blogartikel noch nicht indexiert wurde oder wenn es Indexierungsfehler gibt (etwa „404 Nicht gefunden“ bei gelöschten Seiten). Durch einen Website-Relaunch oder größere Änderungen kann es passieren, dass Seiten aus Versehen aus dem Index fallen. Mit dem Indexierungsbericht kannst du nachverfolgen, ob alle relevanten URLs indexiert sind oder ob vielleicht wichtige Seiten fehlen. Falls im Bereich Fehler oder Ausgeschlossen Einträge auftauchen, gibt die GSC den Grund an – etwa „von robots.txt blockiert“ oder „Alternativseite mit Canonical-Tag“. So weißt du, wo du ansetzen musst, um Indexierungsprobleme zu beheben. Einsteiger sollten insbesondere sicherstellen, dass keine zentralen Seiten unnötig ausgeschlossen sind und technische Fehler zeitnah korrigieren, da nur indexierte Seiten bei Google ranken können.

Für Fortgeschrittene: Erfahrene Nutzer analysieren die Indexabdeckung regelmäßig, um technische SEO-Probleme frühzeitig zu erkennen. Ein plötzlicher Rückgang der indexierten Seiten kann beispielsweise auf technische Fehler hindeuten (etwa ein fehlerhaftes noindex auf vielen Seiten). Mit der GSC lässt sich dann gezielt prüfen, ob neue Inhalte schnell indexiert werden und ob ein technischer Rollout (z.B. neue Seitentemplates) ungewollte Indexierungsfolgen hatte. Sehr hilfreich ist die Validierungs-Funktion: Nachdem man identifizierte Fehler behoben hat, kann man in GSC per Klick „Fehlerbehebung überprüfen“ auslösen. Google crawlt die betroffenen URLs dann bevorzugt erneut und sendet eine Benachrichtigung, sobald alle Fehler als behoben gelten. Fortgeschrittene nutzen zudem den Sitemap-Filter, um die Indexierung gezielt für bestimmte URL-Mengen zu prüfen – etwa um zu sehen, welche Seiten einer eingereichten Sitemap tatsächlich indexiert sind. Alles in allem ist der Indexierungsbericht ein unentbehrliches Werkzeug, um die Technik deiner Seite gesund zu halten: Von der Überwachung der Crawl-Ergebnisse bis zur Kontrolle, ob beim letzten Website-Update keine Indexierungsprobleme entstanden sind.

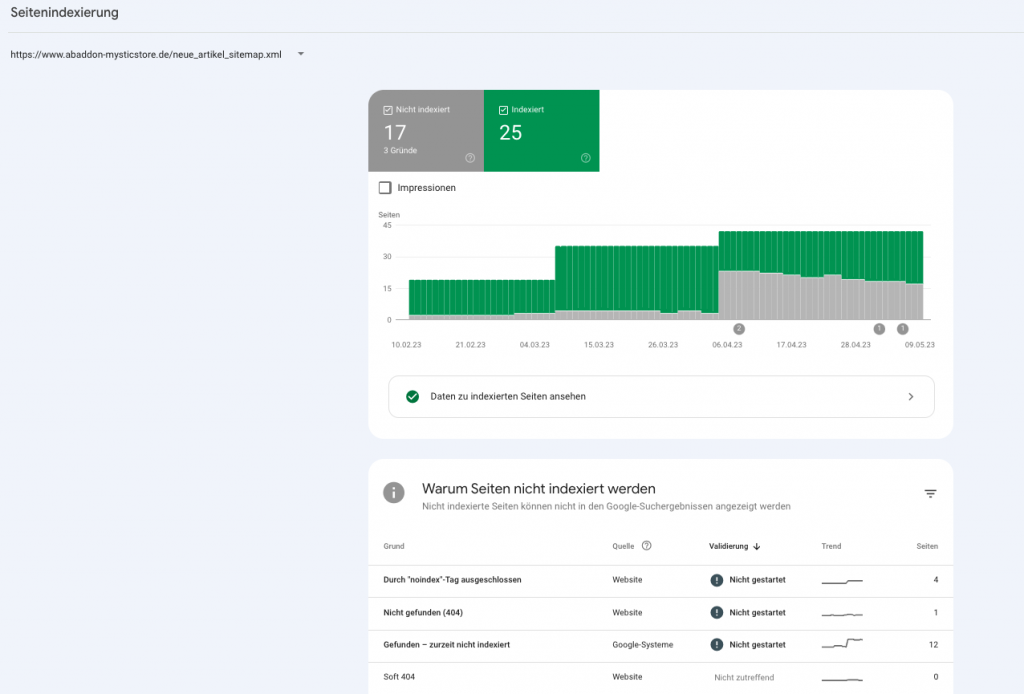

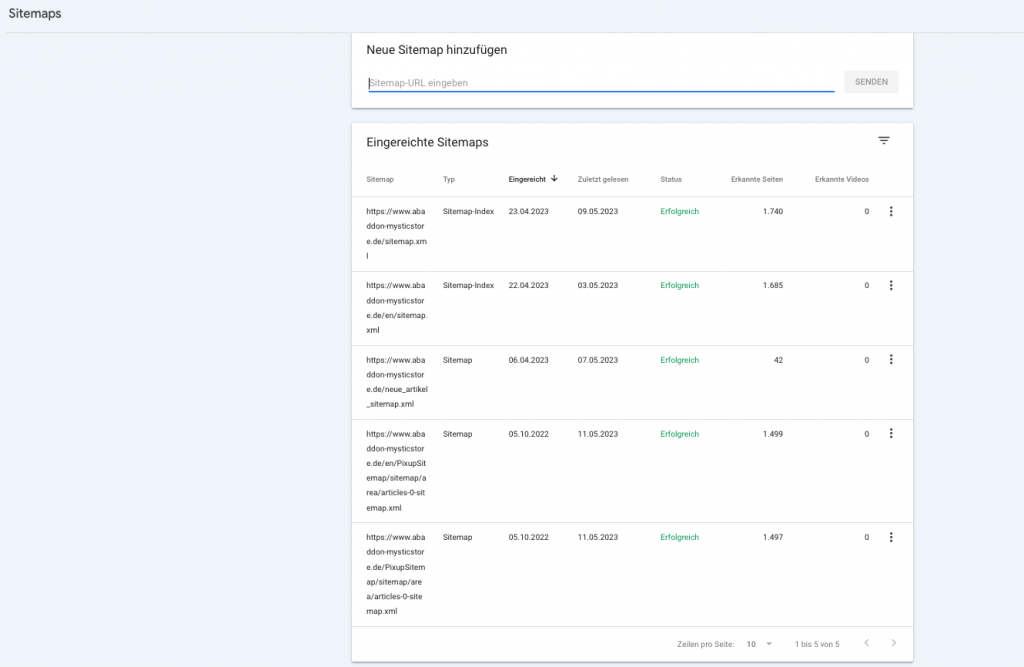

Sitemaps: Inhalte gezielt an Google übermitteln

XML-Sitemaps sind strukturierte Verzeichnisse der URLs deiner Website, die du Google bereitstellen kannst. In der Search Console gibt es dafür den Bereich „Sitemaps“, wo du die URL deiner Sitemap-Datei einreichen und den Verarbeitungsstatus einsehen kannst. Eine Sitemap hilft Google, wichtige Seiten deiner Website schneller zu finden und zu indexieren – besonders bei umfangreichen Websites oder häufig neuen Inhalten ist das sehr wertvoll.

Typische Anwendung: Du gibst z.B. https://www.deine-seite.de/sitemap.xml ins entsprechende Feld ein und klickst auf „Senden“. Google prüft dann sofort, ob die Datei abrufbar und korrekt formatiert ist. Anschließend zeigt der Sitemap-Bericht unter anderem: Wie viele URLs die Sitemap enthält, wie viele davon bereits indexiert sind, und das Datum des letzten Abrufs.

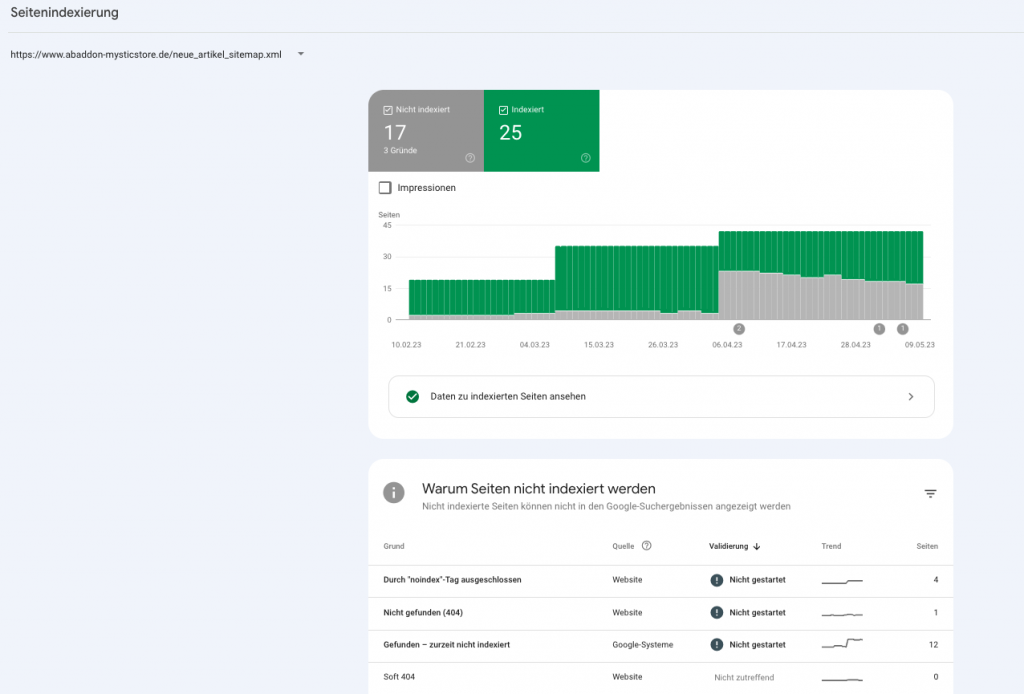

Wie sieht die Index-Abdeckung für eine Sitemap aus?

Im oberen linken Bereich des Abdeckungs-Berichts seht Ihr, dass die Auswertung auf die gewählte Datei eingeschränkt wurde.

In diesem Beispiel sehen wir, dass von den 42 eingereichten Produkten/URLs in dieser Sitemap nur 25 auch wirklich bei Google indexiert sind.

Die restlichen 17 sind aus verschiedenen Gründen derzeit nicht im Google-Index. Als Onlineshopbetreiber sollte man nun versuchen, dies zu verbessern.

In diesem Beispiel sind bspw. 4 URLs in der Sitemap enthalten, die durch ein NOINDEX von der Indexierung ausgeschlossen sind – diese URLs sollten also möglichst auch aus der Sitemap entfernt werden.

1 weiteres Produkt scheint derzeit schon nicht mehr verfügbar zu sein, da die entsprechende URL einen 404-Fehler zurück gibt. Da es sich im Beispiel um eine manuelle Sitemap handelt, sollte also auch diese URL aus der Sitemap entfernt werden.

Ihr seht – nur durch einen kurzen Blick konnten 5 von 17 nicht indexierten URLs schon erklärt werden. Nutzt daher diese Datenfilterung, um fehlerhafte XML-Sitemaps zu optimieren.

Für Einsteiger: Das Einreichen einer Sitemap ist eine der ersten Empfehlungen für neue Websites. Es stellt sicher, dass Google die Struktur deiner Website kennt und nicht versehentlich wichtige Seiten übersieht. Gerade wenn du regelmäßig Blogbeiträge, Produkte oder News veröffentlichst, solltest du eine aktuelle Sitemap pflegen und in GSC hinterlegen. Die Search Console meldet, falls es Fehler in der Sitemap gibt (etwa Syntaxfehler oder nicht erreichbare URLs). So kannst du diese rasch korrigieren. Auch zeigt der Bericht an, ob alle neuen Inhalte erfolgreich erfasst wurden. Beispiel: Wenn du 100 neue Produktseiten hinzugefügt hast und die Sitemap eingereicht wurde, aber nur 20 indexiert sind, weißt du, dass du tiefer nachforschen musst (vielleicht sind die restlichen 80 per noindex markiert oder es gab Crawling-Probleme). Einsteiger profitieren von der Sitemap-Funktion, indem sie Google gewissermaßen einen „Inhaltsverzeichnis“ ihrer Seite geben – für schnellere und vollständigere Indexierung.

Für Fortgeschrittene: Erfahrene SEOs nutzen Sitemaps strategisch. Große Websites setzen oft mehrere Sitemaps ein (z.B. getrennt nach Produktseiten, Blogposts, Kategorien), um den Überblick zu behalten. In der Search Console kann man dann für jede Sitemap sehen, wie viele Seiten indexiert wurden, und gezielt eingreifen, wenn in einer Sektion wenige Seiten im Index landen. Ein Profi-Tipp ist die Kombination mit dem Indexierungsbericht: Filtere den „Seiten“-Bericht nach einer bestimmten Sitemap, um nur die URLs dieser Kategorie zu betrachten. So erkennst du z.B., ob in der „Blogpost-Sitemap“ manche Artikel von Google ignoriert werden und kannst Ursachen erforschen. Darüber hinaus wissen Fortgeschrittene, dass Sitemaps keinen direkten Einfluss auf Rankings haben – sie sorgen lediglich für effizienteres Crawling. Trotzdem sind sie unverzichtbar, um Google bei Relaunches oder Site-Struktur-Änderungen zu unterstützen: Bei einem Domain-Umzug oder großen URL-Änderungen reicht man eine aktuelle Sitemap ein, um Google das Neuladen aller Seiten zu erleichtern. Zusammengefasst geben Sitemaps Power-Usern Kontrolle und Transparenz über die Indexierungsabdeckung und helfen, Crawling-Ressourcen optimal zu lenken.

Core Web Vitals: Ladezeiten und Nutzererlebnis optimieren

Die Core Web Vitals sind Googles Kennzahlen für die Benutzerfreundlichkeit einer Seite in puncto Ladeleistung und Stabilität. In der GSC findest du dafür den Core Web Vitals-Bericht (im deutschen Interface oft unter „Nutzererfahrung“ oder „Seitenerlebnis“ einsortiert). Dieser Bericht wertet die realen Nutzerdaten (Felddaten) deiner Website aus und zeigt für Mobile und Desktop getrennt, welche Seiten gute, verbesserungswürdige oder schlechte Werte aufweisen.

Im Fokus stehen dabei derzeit drei Metriken:

Core Web Vitals – Begriffe erklärt

Largest Contentful Paint (LCP) – Diese Messwert misst die Dauer des Ladevorgangs, bis die Hauptinhalte einer Seite geladen sind. Hier sollten Werte unter 2,5 Sekunden angestrebt werden.

INP (Interaction to Next Paint): Misst die Interaktivität – konkret die Reaktionszeit auf Nutzeraktionen. (INP hat 2024 den früheren FID-Wert ersetzt.) Werte unter 0,2 Sekunden gelten als gut, über 0,5 Sekunden als schlecht.

Cumulative Layout Shift (CLS) – Diese Kennzahl misst die visuelle Stabilität der Seite, d.h. ob sich das Layout der Seite während der Seite verändert, z.B. durch einen Werbe- oder Cookie-Banner oder nachgeladene Elemente.

Die GSC aggregiert diese Werte für deine Seiten und teilt sie in „Gut“, „Optimierung erforderlich“ oder „Schlecht“ ein. Außerdem gruppiert Search Console oft ähnliche Seiten zusammen – z.B. wenn viele URLs eines Seitentyps dasselbe Problem haben, siehst du das auf einen Blick. Ein Klick auf eine Kategorie (z.B. „Mobile – 20 Seiten mit langsamer LCP“) zeigt Details zu den betroffenen Seiten und Beispiel-URLs.

Zusätzlich zeigt die GSC im HTTPS-Bericht (ebenfalls unter Seitenerfahrung), ob alle deine Seiten über eine sichere HTTPS-Verbindung ausgeliefert werden. Eine vollständige HTTPS-Nutzung ist aus SEO-Sicht wichtig, da Google sichere Websites bevorzugt. In der Regel sollte deine gesamte Website auf HTTPS umgestellt sein; falls nicht, unternimm das zeitnah.

Für Einsteiger: Core Web Vitals mögen technisch klingen, sind aber in der Praxis ein Gradmesser für die Performance deiner Website. Auch ohne tiefes Entwicklerwissen kannst du der GSC entnehmen, ob deine Seiten für Nutzer schnell und angenehm laden. Siehst du viele „schlechte“ URLs im Bericht, ist das ein klares Signal: Deine Seite könnte z.B. zu langsam sein, was Besucher vergraulen und dein Google-Ranking beeinträchtigen kann. Als Einsteiger solltest du insbesondere auf größere Probleme achten, die GSC meldet – etwa „LCP zu hoch auf Mobile“. Oft gibt dir die Search Console sogar Hinweise, was die Ursache sein könnte (z.B. „Bilder zu groß“ oder „Server-Antwortzeit zu langsam“). Solche Erkenntnisse kannst du dann nutzen, um mit Entwicklern oder deinem Webmaster zu besprechen, wie sich die Ladezeiten verbessern lassen (z.B. Bilder komprimieren, Hosting optimieren etc.). Motivierend ist: Verbesserst du die Core Web Vitals, profitieren Nutzer und Rankings gleichermaßen – eine Win-Win-Situation. Fange am besten bei Seiten an, die in GSC als „schlecht“ markiert sind, und miss die Fortschritte über die nächsten Wochen.

Für Fortgeschrittene: Für erfahrene SEOs und Webentwickler sind die Core Web Vitals ein wichtiges Monitoring-Instrument. Sie nutzen die GSC-Daten, um Optimierungsmaßnahmen zu priorisieren – z.B. erkennen sie, dass vor allem bestimmte Seitentypen (etwa Produktseiten) Performance-Probleme haben, und setzen dort an. Da die GSC reale Nutzererfahrungen abbildet (anders als Labortests), dienen die Werte auch zur Erfolgskontrolle nach Optimierungen: Änderungen an Bildergrößen, Code oder Caching spiegeln sich oft erst nach einigen Wochen in diesen Berichten wider, aber dann kann man den Effekt klar sehen. Fortgeschrittene kombinieren GSC oft mit anderen Tools: etwa PageSpeed Insights oder Lighthouse für konkrete Verbesserungstipps pro Seite. Dennoch bleibt die GSC unverzichtbar, weil sie alle Seiten im Überblick zeigt und priorisiert – etwas, das einzelne Tests nicht leisten. Wenn z.B. eine neue Slider-Funktion im Shop die CLS-Werte ruiniert, wird es der GSC-Bericht schnell offenbaren. Profis nutzen auch die Validierungsfunktion hier: nachdem z.B. ein LCP-Problem behoben wurde (etwa durch Lazy Loading), kann man „Fehlerbehebung überprüfen“ klicken, und Google bestätigt nach erneuter Datenanalyse, ob die betroffenen URLs nun besser abschneiden. Insgesamt hilft der Core-Web-Vitals-Bericht fortgeschrittenen Nutzern, technische Performance eng mit SEO zu verzahnen – ein essenzieller Teil von modernem Technical SEO, gerade in Zeiten des Page Experience Updates.

Mobile Nutzerfreundlichkeit: Mobiloptimierung sicherstellen

In der Mobile-First-Welt ist eine gute Nutzererfahrung auf Smartphones Pflicht. Die Search Console bietet dazu den Bericht „Nutzerfreundlichkeit auf Mobilgeräten“, der prüft, ob deine Seiten für mobile Geräte optimiert sind. Google listet hier typische Usability-Probleme auf, die auf kleinen Bildschirmen auftreten können, u.a.:

- „Text ist zu klein zum Lesen“ – Schriftgrößen, die auf dem Handy unleserlich sind.

- „Anklickbare Elemente liegen zu dicht beieinander“ – Buttons oder Links, die mit dem Finger schwer zu treffen sind, weil sie zu eng stehen.

- „Inhalt breiter als der Bildschirm“ – Seiten, bei denen man horizontal scrollen muss, weil Elemente nicht responsiv skaliert sind.

- „Darstellungsbereich nicht festgelegt“ – fehlt das responsive Meta-Viewport-Tag, wird die Seite nicht richtig skaliert.

- „Inkompatible Plugins“ – z.B. alte Flash-Inhalte, die auf Mobilgeräten nicht laufen.

Für Einsteiger: Die mobile Nutzerfreundlichkeit ist ein Bereich, den man nicht vernachlässigen darf, da Google die mobile Version einer Seite zur Indexierung heranzieht (Mobile-First-Indexierung) und auch die Nutzer zunehmend mobil unterwegs sind. Einsteiger sollten GSC nutzen, um offensichtliche Mobile-Probleme schnell zu erkennen und zu beheben. Bekommt man etwa die Meldung „Text ist zu klein zum Lesen“, kann die Lösung sein, die CSS-Stilvorlagen anzupassen und größere Schriftgrößen für mobile Viewports zu definieren. Oder wenn „anklickbare Elemente zu dicht“ liegen, sollte man Abstände in der mobilen Ansicht vergrößern. Die GSC liefert hier eine klare Liste der betroffenen Seiten – man kann dann selbst auf dem eigenen Smartphone testen, wie die Seiten aussehen, oder den Mobile-Friendly-Test von Google nutzen. Motivierend für Einsteiger: Schon mit relativ einfachen Änderungen (responsive Design einsetzen, Schriftgrößen und Buttons optimieren) lässt sich eine große Wirkung erzielen: Nutzer bleiben länger auf der Seite, Absprungraten sinken und Google belohnt die mobilfreundliche Seite mit potenziell besseren Rankings.

Für Fortgeschrittene: Erfahrene SEOs betrachten den Mobile-Usability-Bericht als Qualitätskontrolle nach jedem größeren Update. Bei einem Website-Relaunch oder Design-Rollout prüfen Profis hier umgehend, ob neue Fehler aufgetaucht sind – z.B. ob ein neues Popup die mobilen Seiten unbenutzbar gemacht hat. Sie kennen die Google-Richtlinien (keine zu intrusive Interstitials etc.) und nutzen GSC als Frühwarnsystem: „Die Search Console meldet 10 Seiten mit ‚Inhalt breiter als Bildschirm‘ – wir haben wohl irgendwo ein CSS-Problem auf dem neuen Template.“ Diese Probleme können dann im Entwicklungsprozess schnell behoben werden, bevor Nutzer sie bemängeln. Außerdem setzen fortgeschrittene SEOs Mobile- und Core-Web-Vitals-Daten in Zusammenhang: Vielleicht sieht man, dass Seiten mit bestimmten Mobile-Usability-Fehlern auch höhere Absprungraten in Analytics zeigen – ein Indiz, dort dringend zu optimieren. Wichtig ist auch das Bewusstsein, dass Mobile Usability ein Rankingfaktor ist. Profis nutzen also GSC, um alle mobile „Ampeln“ auf Grün zu halten. Treten vermehrt Fehler auf, kann das auch auf CMS-Probleme oder Plugin-Fehler hindeuten (z.B. ein WordPress-Plugin, das mobil schlechte Effekte hat). Durch regelmäßiges Monitoring der Mobilfunktionen in GSC behalten erfahrene Nutzer die Mobile-Tauglichkeit der Website konstant im Griff – und damit einen wichtigen Wettbewerbsvorteil.

Sicherheitsprobleme & Manuelle Maßnahmen: Warnungen ernst nehmen

Die wenig erfreulichen, aber wichtigen Berichte „Manuelle Maßnahmen“ und „Sicherheitsprobleme“ liegen in der GSC meist gemeinsam unter „Sicherheit & Manuelle Maßnahmen“. Beginnen wir mit den Manuellen Maßnahmen: Hier zeigt Google an, ob deine Website gegen Qualitätsrichtlinien verstoßen hat und dafür von einem Google-Mitarbeiter manuell abgestraft wurde. Falls ja, sieht man die Art des Verstoßes und welche Auswirkungen die Maßnahme hat (z.B. „Einige Seiten sind nicht mehr in Google verfügbar“ oder „Die gesamte Website ist herabgestuft“).

Häufige Gründe für manuelle Maßnahmen (Auszug von Google):

- Unnatürlicher Linkaufbau eingehend: z.B. Kauf von Links, manipulative Backlinks.

- Unnatürliche Links ausgehend: deine Seite setzt Spam-Links zu anderen Seiten (z.B. bezahlte DoFollow-Links).

- Cloaking/Versteckter Inhalt: dem Googlebot werden andere Inhalte gezeigt als dem Nutzer, oder es gibt unsichtbaren Spam-Text auf der Seite.

- Spam-Inhalte / Thin Content: automatisch generierte oder extrem dünne Inhalte ohne Mehrwert.

- Missbrauch strukturierter Daten: z.B. falsche Verwendung von Markup, um Suchergebnisse zu manipulieren (etwa Fake-Bewertungen auszeichnen).

- Von Nutzern erstellter Spam: Spam-Beiträge in Foren, Kommentaren oder Gästebüchern, die auf deiner Seite gehostet sind.

Wenn eine manuelle Maßnahme vorliegt, möchte man das sofort wissen, denn die Folgen sind meist drastisch: Die Seite verliert an Sichtbarkeit oder verschwindet ganz aus bestimmten Ergebnissen. GSC sendet in der Regel auch eine Nachricht, falls eine neue Maßnahme ergriffen wurde.

Für Einsteiger: Im Idealfall wirst du diesen Bericht nie „in Aktion“ sehen, denn ehrliche Websites ohne Black-Hat-SEO-Tricks bekommen selten manuelle Strafen. Dennoch: Es lohnt sich zu verstehen, was hier passieren kann. Sollte deine Website z.B. gehackt worden sein und Spam verbreiten, könnte Google eine manuelle Maßnahme verhängen (z.B. „Gehackter Spam“). Oder wenn eine unbedachte SEO-Agentur massenhaft minderwertige Links aufgebaut hat, kann „unnatürliche eingehende Links“ angezeigt werden. Als Einsteiger solltest du solche Warnzeichen sehr ernst nehmen. GSC zeigt genau, welcher Verstoß festgestellt wurde und welche Bereiche betroffen sind. Das Tool bietet auch einen Link zu Googles Richtlinien und oft Hinweise zur Behebung. Dein Vorgehen wäre dann: Problem identifizieren, beheben und einen „Wiederaufnahmeantrag“ stellen (in GSC als „Überprüfung anfordern“ bezeichnet). In dieser Nachricht an Google beschreibst du, was du korrigiert hast. Einsteiger sollten bei Unsicherheit unbedingt Googles Dokumentation konsultieren oder einen SEO-Experten hinzuziehen, denn eine erfolgreiche Reconsideration erfordert, dass wirklich alle Verstöße beseitigt wurden. Die gute Nachricht: Wenn du sauber arbeitest, wirst du vermutlich nie eine manuelle Maßnahme erhalten – aber es ist beruhigend zu wissen, dass GSC dich sofort alarmiert, falls doch.

Für Fortgeschrittene: Profis haben oft mit manuellen Maßnahmen zu tun, gerade wenn sie neue Kundenprojekte übernehmen, die in der Vergangenheit „unsaubere“ SEO praktiziert haben. Für sie ist der GSC-Bericht essentiell, um den Status einer Domain zu prüfen. Typisch ist etwa ein Blick ins GSC-Protokoll nach einem Website-Audit: „Liegt vielleicht eine alte Abstrafung wegen Linkkauf vor?“. Falls ja, steuern erfahrene SEOs die Gegenmaßnahmen: z.B. toxische Links per Disavow-Datei entwerten und danach über GSC die Wiederaufnahme beantragen. Die Search Console gibt genau an, welcher Verstoß vorlag und nimmt auch den Antrag entgegen. Profis wissen, wie ein solcher Antrag formuliert sein sollte (transparent darlegen, was bereinigt wurde, und Besserung geloben). Außerdem überwachen sie kontinuierlich die GSC-Nachrichten: Kommt eine neue manuelle Maßnahme, muss sofort gehandelt werden, denn jeder Tag unter Penalty kostet Traffic und Umsatz. In größeren Firmen richten SEOs teils E-Mail-Benachrichtigungen ein, um keine Warnung zu verpassen. Ein fortgeschrittener Tipp: Vorbeugung ist die beste Medizin – daher meiden Profis riskante SEO-Taktiken, die überhaupt erst zu manuellen Maßnahmen führen könnten. Dennoch gilt: Die Search Console ist der erste Indikator, falls Google manuell eingreift, und ermöglicht es Profis, schnell zu reagieren und den Schaden zu begrenzen.

Sicherheitsprobleme: Schutz vor Hacks und Malware

Neben manuellen Penalties informiert dich GSC im Bereich „Sicherheitsprobleme“, ob deine Website gehackt oder anderweitig kompromittiert wurde. Google überwacht Webseiten und warnt, wenn z.B. Malware gefunden wird, Phishing-Inhalte entdeckt werden oder Spam eingefügt wurde, der auf eine Hack-Attacke hindeutet. Typische Sicherheitsprobleme, die GSC meldet:

- Malware & schädliche Software: Der Inhalt deiner Seite versucht ggf. Schadcode auf Besuchergeräte zu übertragen.

- Irreführende Seiten (Social Engineering): Seiten, die vorgeben etwas zu sein (z.B. gefälschte Login-Seiten) oder Nutzer zu gefährlichen Aktionen verleiten.

- Gehackte Seiten mit Spam: Hacker haben neue, spammy Seiten auf deiner Domain erstellt oder legitime Seiten mit Spam-Links/Keywords versehen.

Wenn Google so etwas feststellt, erscheint in GSC ein Warnhinweis – oft zusätzlich zu sichtbaren Effekten, wie einem roten „Diese Website wurde möglicherweise gehackt“-Hinweis in den Suchergebnissen oder einer Blockierung durch den Browser (Google Safe Browsing).

Für Einsteiger: Ein Sicherheitsproblem auf der eigenen Website kann einschüchternd sein. GSC hilft dir in dieser Stresssituation, konkret zu erkennen, was passiert ist. Zum Beispiel zeigt der Bericht Beispiel-URLs, die betroffen sind (etwa unbekannte Seiten unter deiner Domain, die du nie erstellt hast – ein klares Zeichen für Hackerspam). Oder er meldet „Schadsoftware gefunden“ und nennt die betroffenen Dateien. Als Einsteiger solltest du sofort handeln: Trenne die Website nach Möglichkeit vom Netz (deaktiviere unsichere Skripte), informiere deinen Hoster oder Entwickler und beginne mit der Bereinigung. Google bietet in der Search Console und der Dokumentation Leitfäden an, wie man gehackte Seiten säubert. Nachdem du alle Schadsoftware entfernt und Sicherheitslücken geschlossen hast, kannst du in GSC eine Überprüfung anfordern. Google wird dann deine Seite erneut prüfen, was einige Tage bis Wochen dauern kann. Besteht kein Risiko mehr, verschwinden die Warnungen in der Suche meist. Wichtig: Nimm Sicherheitswarnungen ernst! Sie schützen nicht nur deine Besucher, sondern auch deinen Ruf. Nichts ist schlimmer, als wenn Nutzer vor deiner Seite gewarnt werden oder Daten gestohlen werden – daher im Zweifel Hilfe von Profis holen. GSC gibt dir aber das gute Gefühl, dass du Bescheid bekommst, wenn etwas faul ist, anstatt im Dunkeln zu tappen.

Für Fortgeschrittene: Für professionelle Webmaster und Admins ist die GSC eine zusätzliche Alarmanlage neben ihren Server-Monitoring-Tools. Sicherheitsprobleme können gravierende SEO-Folgen haben (Deindexierung, Vertrauensverlust), daher richten Profis automatisierte Alerts ein. Wenn GSC ein Problem meldet – z.B. „gehackte URL-Injection“ –, starten sie umgehend Incident-Response-Prozesse. Sie nutzen GSCs Hinweise (betroffene URLs, Code-Beispiele) zur forensischen Analyse: Wo ist der Eindringling rein? Welche Dateien wurden modifiziert?. Fortgeschrittene Anwender wissen auch, dass das URL-Prüftool bei Hack-Findings nützlich sein kann: Man kann darüber eine gehackte Seite rendern, ohne sie im eigenen Browser zu öffnen (der Hinweis „Rufe infizierte Seiten nicht im Browser auf“ ist wichtig – GSC bietet hier eine sichere Alternative, um den Schadcode zu inspizieren). Nach Bereinigung stellen Profis den Wiederherstellungsantrag mit einer genauen Beschreibung der Maßnahmen (z.B. „Malware entfernt, Serverloch gepatcht, Passwörter geändert“). In der Regel hebt Google dann die Warnungen auf und die Rankings erholen sich. Generell setzen erfahrene Webmaster aber auf Prävention: Regelmäßige Updates, Backups, Firewall und Monitoring, damit es gar nicht erst zum GSC-Alarm kommt. Sollte es passieren, ist die Search Console ihr bester Freund, um zügig zu reagieren und Schaden von der Website und den Nutzern abzuwenden.

Weitere wichtige Berichte und Funktionen

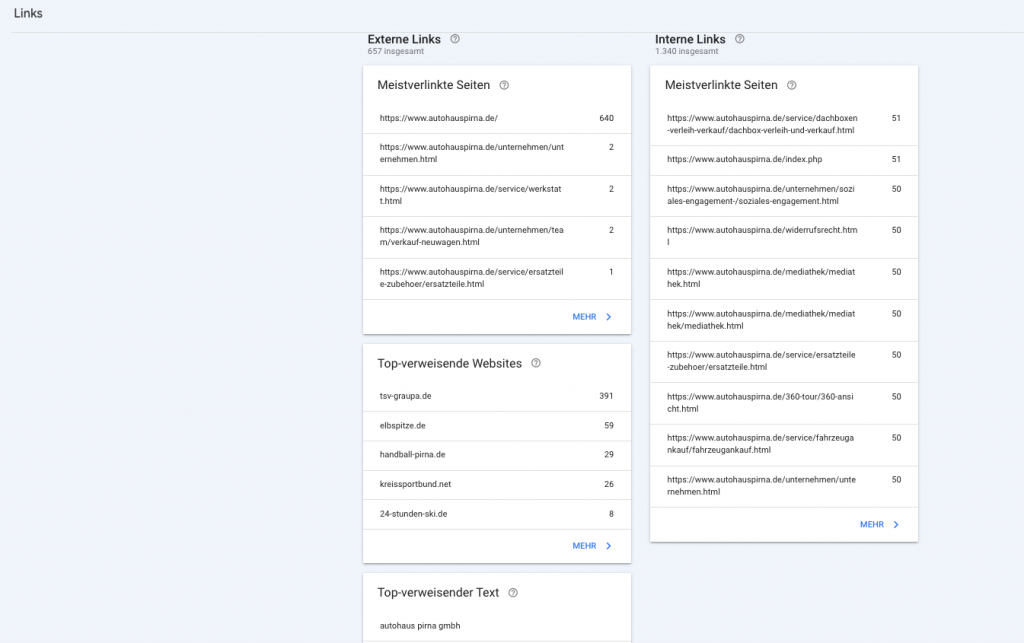

Links: Externe und interne Verlinkungen analysieren

Neben den Kernfunktionen bietet die Search Console noch zahlreiche weitere Berichte und Tools, die sowohl Einsteigern als auch Profis helfen, ihre Website zu optimieren. Hier ein Überblick über die wichtigsten zusätzlichen Funktionen:

Unter „Links“ fasst GSC alle Daten zu Backlinks (externe Links) und internen Links zusammen. Dieser Bereich ist das Rückgrat deiner SEO-Analyse der Linkstruktur. Die Search Console zeigt dir zum Beispiel:

- Meistverlinkte Seiten (extern): Welche Seiten deiner Website erhalten die meisten eingehenden Links von anderen Websites? (und wie viele).

- Top-verweisende Websites: Von welchen Domains kommen die meisten Backlinks? Du kannst hier auf Domain- oder URL-Ebene sehen, wer auf dich verlinkt.

- Häufigste Linktexte (Anchor-Texte): Welche Linktexte werden am häufigsten verwendet, wenn andere auf deine Seite verlinken?

- Meistverlinkte interne Seiten: Welche Seiten auf deiner Website haben die meisten internen Links von deinen eigenen Seiten erhalten?

Wozu das? Externe Links (Backlinks) sind weiterhin ein bedeutender Rankingfaktor. Mit GSC kannst du herausfinden, welche Websites auf dich verlinken und welche Inhalte besonders oft verlinkt werden. So erkennst du z.B. hochwertige Backlinks – oder entdeckst Spam-Links, die potenziell schaden. Einsteiger können hier ein Gefühl dafür entwickeln, wie „bekannt“ die eigene Seite im Web ist und von wo Besucher kommen könnten. Interne Links wiederum sind wichtig für die Seitenhierarchie und Crawling: GSC zeigt, ob wichtige Seiten genügend intern verlinkt sind oder ob manche Seiten quasi auf dem Abstellgleis stehen.

Für Einsteiger: Schau dir zunächst die externe Links an. Gibt es überraschende Websites, die auf dich linken? Vielleicht findest du Potenzial für Partnerschaften oder entdeckst Links von zweifelhaften Seiten. Bei letzterem keine Panik – ein paar Spam-Links hat jeder. Wichtig ist, auffällige Muster zu erkennen (z.B. hunderte Links von einer dubiosen Quelle). Bei internen Links kannst du prüfen, ob deine wichtigsten Seiten (z.B. Hauptprodukte oder Dienstleistungen) auch tatsächlich oft intern verlinkt werden – im Menü, in Artikeln etc. Falls nicht, solltest du die interne Verlinkung stärken, damit Google die Seite als wichtig einstuft. Einsteiger nutzen diesen Bericht, um die Struktur ihrer Website bewusster zu gestalten: Welche Seiten verlinke ich intern wie häufig? Und welche Seiten scheinen für andere so relevant zu sein, dass sie verlinkt werden?

Für Fortgeschrittene: Profis führen mit den GSC-Linkdaten regelmäßige Backlink-Audits durch. Sie exportieren die Liste der eingehenden Links (GSC ermöglicht den Download als CSV/Excel) und analysieren sie mit Tools oder manuell, um toxische Links zu finden. Schädliche Links (etwa von Spam-Seiten oder PBNs) entwerten sie ggf. mit dem Disavow-Tool – das ist zwar nicht mehr direkt im GSC-Menü, aber weiterhin verfügbar. GSC dient hier als erste Anlaufstelle, bevor man auf spezialisierte Backlink-Checker umsteigt. Gleichzeitig optimieren Fortgeschrittene die interne Verlinkung datengetrieben: Sie sehen, welche wichtigen Seiten noch zu wenig intern verlinkt sind und verbessern das gezielt (denn interne Links steuern PageRank-Fluss). Auch Erfolge von Offpage-Kampagnen lassen sich hier ablesen: Wurde z.B. eine PR-Aktion durchgeführt, kann man in GSC erkennen, welche neuen Backlinks dazugekommen sind. Insgesamt liefert der Linkbericht den Profis eine grobe, aber Google-verifizierte Linkübersicht, die sie in ihre SEO-Strategie einfließen lassen.

Beispiel: Ein Online-Shop sieht in GSC, dass viele Backlinks auf einen Blogartikel zeigen, der aber kaum intern verlinkt ist. Ein SEO-Profi würde diese Gelegenheit nutzen und vom beliebten Blogartikel stärker auf relevante Produktkategorien verlinken (interne Links), um Linkjuice sinnvoll zu verteilen und die Rankings der Produktseiten zu verbessern.

Crawling-Statistiken: Googles Crawl-Verhalten verstehen

Die Crawling-Statistiken befinden sich etwas versteckt unter GSC → Einstellungen → Crawling-Statistiken, bieten aber vor allem fortgeschrittenen Nutzern wertvolle Einblicke. In diesem Bericht erfährst du:

- Anzahl der Crawl-Anfragen pro Tag: Wie oft ruft Googlebot deine Seiten ab?

- Datenmenge heruntergeladen: Wieviel KB/MB an Daten lädt Googlebot bei dir (Hinweis auf Seitengröße und Medien).

- Durchschnittliche Response-Zeit: Wie schnell reagiert dein Server im Schnitt auf Googlebot-Anfragen.

Zusätzlich kannst du die Daten nach Dateityp, Statuscode, Zweck und Googlebot-Typ aufschlüsseln. So siehst du z.B., ob Googlebot gerade besonders viele Bilder crawlt, ob viele 404-Antworten auftreten, ob hauptsächlich neue Seiten oder aktualisierte gecrawlt werden und ob der Smartphone-Googlebot häufiger vorbeischaut als der Desktop-Crawler.

Für Einsteiger: Dieser Bericht ist recht technisch und für absolute SEO-Anfänger weniger unmittelbar nützlich. Dennoch lohnt ein Blick: Du bekommst ein Gefühl dafür, wie Googlebot deine Seite besucht. Siehst du z.B., dass Google sehr selten crawlt (vielleicht nur wenige Male am Tag bei einer großen Seite), könnte das bedeuten, dass deine Seite noch wenig bekannt ist oder du in der Vergangenheit Crawl-Probleme hattest. Einsteiger können hier auch erkennen, ob es auffällige Fehler gibt – etwa täglich Hunderte 404-Fehler (dann solltest du kaputte interne Links reparieren). Insgesamt hilft es, die „Google-Perspektive“ einzunehmen: Googlebot hat begrenztes Crawl-Budget, und dieser Bericht zeigt, wie viel davon deine Seite in Anspruch nimmt. Wenn du feststellst, dass Google ganz viele irrelevante URLs (z.B. mit SessionIDs oder Filterparametern) crawlt, könntest du überlegen, diese per robots.txt zu blockieren oder per noindex zu entschärfen. Für Einsteiger reicht es aber oft, zu wissen: Google kommt X-mal pro Tag vorbei und hat Y Fehler gefunden – das spornt an, die Seite im technischen Sinne sauber zu halten.

Für Fortgeschrittene: Hier spielt die Musik. Profis überwachen die Crawling-Statistiken, um Crawl-Effizienz und Servergesundheit zu beurteilen. Ein plötzlicher Einbruch der Crawl-Rate könnte auf Serverprobleme oder schlechte Erreichbarkeit hindeuten. Umgekehrt kann ein Spike auf eine neue URL-Struktur oder Sitemap-Einreichung zurückzuführen sein – gut zu wissen, ob Google eine Änderung schnell verarbeitet. Die Aufschlüsselung nach Dateityp und Statuscode ist Gold wert: Wenn man sieht, dass z.B. 30% der Googlebot-Anfragen mit HTTP-404 antworten, läuft etwas falsch (zu viele broken links oder veraltete URLs in Sitemaps). Oder wenn Bilder einen Großteil des Crawl-Budgets fressen, könnte man überlegen, ob man unnötige Bildvarianten per robots.txt aussperrt, um dem Googlebot mehr Fokus auf HTML zu geben. Fortgeschrittene nutzen diese Daten auch, um das Crawl-Budget zu optimieren – besonders bei sehr großen Sites mit tausenden URLs. Sie stellen sicher, dass Google die wichtigen Bereiche bevorzugt crawlt (z.B. durch interne Verlinkung und Sitemaps steuern) und nicht an unwichtigen Seiten „hängen bleibt“. Ein weiteres Szenario: Nach einem Relaunch checken Profis, ob Google alle neuen URLs crawling-technisch erfassen kann oder ob viele Serverfehler auftreten (vielleicht durch fehlerhafte Redirects). Die Response-Zeit wiederum verrät, ob der Server eventuell überlastet oder langsam ist – was negative Auswirkungen haben kann, wenn Google zu langsam bedient wird. Insgesamt erlauben die Crawling-Statistiken einem erfahrenen SEO oder Admin, Googlebots Verhalten genau zu beobachten und proaktiv dafür zu sorgen, dass Crawl-Budget und Indexierung so effizient wie möglich ablaufen.

Strukturierte Daten und Verbesserungsberichte: Rich Results nutzen

Unter dem Menüpunkt „Verbesserungen“ in GSC erscheinen diverse Berichte zu strukturierten Daten und sogenannten Rich Results (erweiterten Suchergebnissen). Google zeigt hier alle erkannten Markups auf deiner Website an – von FAQ-Schema über Breadcrumbs/Navigationspfade bis hin zu branchenspezifischen Markups wie Produktdaten, Rezensionen, Veranstaltungen etc..

Strukturierte Daten sind Zusatzinformationen im HTML-Code (nach Schema.org-Standards), die Google helfen, Inhalte besser zu verstehen. Bei korrekter Einbindung können sie in den Suchergebnissen zu auffälligeren Darstellungen führen (Rich Snippets mit Sternbewertungen, Preisen, Veranstaltungsdaten, Sitelinks-Suchfelder und mehr).

Die Search Console analysiert automatisch, ob diese Markups korrekt sind und ob alle Pflichtangaben vorhanden sind. In den Berichten sieht man dann für jede Markup-Art:

- Gültige Elemente: Seiten, bei denen alles richtig implementiert wurde.

- Warnungen: Seiten, die zwar ein Rich-Result erhalten könnten, aber wo optionale Felder fehlen oder kleinere Probleme bestehen.

- Fehler: Seiten, bei denen das Markup nicht korrekt ist, sodass sie kein Rich Result bekommen können.

Für Einsteiger: Wenn du gerade erst beginnst, dich mit strukturierten Daten zu befassen, bietet GSC einen guten Einstieg. Vielleicht nutzt du ein CMS-Plugin, das FAQ-Markup oder Rezept-Markup ausgibt – schau in der GSC nach, ob diese als „FAQ“ oder „Rezepte“ im Verbesserungen-Bereich auftauchen. Du wirst sehen, ob Google sie fehlerfrei auslesen konnte. Ein großer Vorteil: GSC nennt konkrete Fehlermeldungen, z.B. „field author missing“ oder „Ungültiger Wert für ratingValue“. So weißt du, was du im Markup korrigieren musst. Für Einsteiger lohnt es sich, schrittweise Markups auszuprobieren und via GSC zu checken. Der sichtbare Nutzen ist motivierend: Rich Snippets können deine Suchergebnis-Darstellung verbessern – was oft zu höherer Klickrate führt. Zum Beispiel, wenn du ein Local Business Markup oder Produkt Markup einfügst und Google daraufhin Sterne-Bewertungen und Preis im Snippet anzeigt, wirst du vermutlich mehr Aufmerksamkeit in den SERPs erhalten. Lass dich also von den GSC-Verbesserungsberichten leiten: Sie zeigen, wo du schon alles richtig machst („gültig“) und wo du noch optimieren oder Fehler beheben solltest, um das volle Potenzial strukturierter Daten zu nutzen.

Für Fortgeschrittene: Erfahrene SEOs werden die Verbesserungsberichte laufend im Auge behalten, insbesondere wenn die Website umfangreich strukturierte Daten nutzt. Für sie ist GSC ein Qualitätscheck: Änderungen am Markup (z.B. durch CMS-Updates) können Fehler einschleusen – GSC meldet das sofort. Profis setzen strukturierte Daten strategisch ein, um Rich Results zu erzielen, die in ihrer Branche relevant sind (Produktrichcards im E-Commerce, Rezensionen für Blogs, Rezeptkarten für Food-Seiten, Job Postings für Jobportale etc.). Die Search Console dient dabei als Monitoring-Tool, ob all diese Markups korrekt funktionieren. Treten Fehler auf, priorisieren sie deren Behebung, weil verschenkte Rich-Snippet-Möglichkeiten gleichbedeutend mit entgangenem Traffic sind. Außerdem nutzen sie GSC, um Erfolg zu messen: Wenn z.B. nach Implementierung von FAQ-Schema plötzlich der FAQ-Bericht 50 gültige Elemente zeigt, kann man in den Leistungsdaten beobachten, ob sich die CTR dieser Seiten verbessert hat. Ein weiterer Aspekt: GSC informiert auch, wenn neue Arten von Markups unterstützt werden oder Daten unvollständig sind. So bleiben Profis up-to-date, welche strukturierten Daten sie noch einbauen könnten. Zusammenfassend verwenden fortgeschrittene Nutzer die Verbesserungsberichte, um die technische Integrität und den Nutzen strukturierter Daten auf ihrer Seite sicherzustellen. Das Ergebnis sind saubere Markups, die Google reibungslos auslesen kann – was in der Suche mit reicherern Ergebnissen und besseren Nutzerinfos belohnt wird.

Weitere nützliche Tools in der Search Console

Abseits der großen Berichte beherbergt die GSC noch ein paar zusätzliche Werkzeuge, die vor allem in speziellen Fällen hilfreich sind:

- URL-Entfernungstool: Damit kannst du kurzfristig Seiten aus den Suchergebnissen entfernen. Wenn beispielsweise sensible oder falsche Informationen veröffentlicht wurden, kannst du über „Entfernen“ einen Antrag stellen, die URL temporär (für ~6 Monate) ausblenden zu lassen. Das ist keine Löschung aus dem Index, aber eine wichtige Firefall-Funktion bei dringendem Bedarf. Tipp: Nutze es vorsichtig und nur mit gutem Grund, da das Entfernen natürlich den Traffic dieser Seite kappt. Parallel solltest du das Problem an der Quelle beheben (Inhalt löschen/korrigieren).

- Adressänderung: Ziehst du mit deiner Website auf eine neue Domain um (z.B. rebranding von alte-domain.de zu neue-domain.de), kannst du Google über die GSC unter Einstellungen → Adressänderung darüber informieren. Das beschleunigt die Übertragung von Rankings und Index auf die neue Domain und hilft, Ranking-Verluste beim Domainwechsel zu vermeiden.

- Benachrichtigungen und Reports: GSC sendet dir Nachrichten direkt ins Dashboard (und optional per Mail), z.B. über neu erkannte Probleme oder abgeschlossene Überprüfungen. Fortgeschrittene Nutzer nehmen diese Warnungen ernst und reagieren schnell, denn oft sind es Frühindikatoren – etwa Hinweis auf steigende 404-Fehler oder Indexierungsprobleme, bevor die Rankings leiden.

Best Practices für deinen SEO-Alltag: Wie du die Search Console effektiv nutzt

Zum Abschluss gebe ich dir einige bewährte Strategien und Tipps, damit du als SEO-Anfänger das Optimum aus der Google Search Console herausholst:

- Regelmäßig reinschauen: Mach dir die GSC zur Gewohnheit. Prüfe mindestens einmal pro Woche die wichtigsten Berichte. So entgehen dir keine neuen Fehlermeldungen oder Chancen. Bei größeren Änderungen an der Website (Relaunch, neue Kampagnen) gerne auch häufiger kontrollieren.

- Warnmeldungen ernst nehmen: Reagiere zeitnah auf Fehlermeldungen in der Search Console. Neue Indexierungsfehler, ein plötzlicher Anstieg von 404-Seiten oder Sicherheitswarnungen solltest du sofort untersuchen und beheben. Bestätige anschließend in der GSC die Problemlösung (z. B. „Als behoben markieren“), damit Google weiß, dass du dich gekümmert hast.

- Snippets und CTR optimieren: Nutze die Leistungsdaten, um deine Meta-Titles und Descriptions zu verbessern. Identifiziere Seiten mit hoher Impression, aber niedriger Klickrate (CTR). Oft lässt sich die CTR steigern, indem der Seitentitel prägnanter formuliert oder der Beschreibungstext neugieriger gemacht wird – natürlich immer im Rahmen dessen, was der Nutzer auf der Seite auch tatsächlich vorfindet. Eine höhere CTR kann bei gleichbleibendem Ranking schon für mehr Traffic sorgen.

- Ranking-Potenziale identifizieren: Schau dir Keywords an, für die deine Seite auf den Positionen ~5–20 rankt (also knapp außerhalb der Top-Positionen oder auf Seite 2). Diese Suchanfragen haben oft Potenzial für mehr – „Low-Hanging Fruits“, an denen du mit Onpage-Optimierungen arbeiten kannst. Überarbeite z. B. den Inhalt der entsprechenden Seite, füge mehr Details hinzu oder baue interne Links von anderen relevanten Seiten ein, um das Ranking anzuschieben.

- Neue Keywords und Content-Ideen finden: Die GSC zeigt dir viele Suchanfragen, über die Nutzer zu dir gelangen. Darunter entdeckst du eventuell Keywords, die thematisch passen, aber für die du noch gar nicht bewusst optimiert hast. Diese Begriffe können Inspiration für neue Inhalte oder Erweiterungen bestehender Inhalte sein. Verwende die Suchanalyse also auch als Keyword-Research-Tool, um deine Content-Strategie zu füttern.

- Sitemap & Index stets aktuell halten: Stelle sicher, dass deine Sitemap immer alle wichtigen URLs enthält und keine veralteten Seiten. Bei größeren Änderungen (z. B. viele neue Seiten, größere Umstrukturierung) reiche die Sitemap erneut ein. Lösche oder noindex-iere Seiten, die nicht mehr relevant sind, damit sie in der GSC nicht dauerhaft als „ausgeschlossen“ aufscheinen. Ein sauberer Index wirkt professionell und hilft Google, den Fokus auf deine wichtigsten Inhalte zu legen.

- Interne Verlinkung optimieren: Nutze den Links-Bericht, um Seiten mit wenigen internen Links aufzuspüren. Überlege, wo du innerhalb deines Contents sinnvoll auf diese Seiten verlinken kannst. Eine starke interne Verlinkung verbessert die Crawlability und verteilt „Link Equity“ innerhalb deiner Website, was sich positiv auf Rankings auswirken kann. Ebenso kannst du im Links-Bericht sehen, welche externen Seiten dich verlinken – bedanke dich ggf. bei diesen oder halte den Kontakt, um ggf. in Zukunft weitere Verlinkungen zu erhalten.

- Geschwindigkeit und mobile Nutzbarkeit verbessern: Die Core Web Vitals geben dir Anhaltspunkte, welche Seiten Performance-Probleme haben. Investiere in technische Optimierungen (z. B. Bildoptimierung, Code-Minifizierung, schnelles Hosting), wenn viele Seiten als „langsam“ markiert sind. Zwar sind die Ladezeit & Nutzererfahrung nur ein Rankingfaktor, aber sie beeinflussen das Nutzerverhalten stark – und damit indirekt auch deinen SEO-Erfolg. Mobile Usability ist weiterhin kritisch für die Zufriedenheit der Nutzer. Teste deine Seite daher regelmäßig mit Mobilgeräten oder Tools wie Googles Mobil-Test und behebe Darstellungsprobleme (z. B. Inhalte brechen aus dem Bildschirm heraus, Buttons zu nah beieinander etc.).

- GSC-Daten in die Gesamtstrategie einbinden: Alle Informationen der Search Console kannst du für deine SEO-Strategie nutzen, um den Traffic zu steigern. Zum Beispiel kannst du GSC mit Google Analytics verknüpfen, um Suchanfragen auch dort in Berichten zu sehen. Oder exportiere GSC-Daten, um sie mit anderen Quellen (etwa Rankings aus SEO-Tools) zu kombinieren. Die GSC dient dir als Kompass, um den Erfolg deiner SEO-Maßnahmen zu messen und neue Maßnahmen datenbasiert zu planen.

Bonus-Tipp: Die Google Search Console und der Screaming Frog

Zum Abschluss noch ein fortgeschrittener Tipp, der über die Search Console selbst hinausgeht: die Verknüpfung von GSC mit dem Tool Screaming Frog. Screaming Frog (SF) ist ein Desktop-Programm, das als Website-Crawler funktioniert. Es durchsucht Deine Website ähnlich wie ein Suchmaschinen-Bot und listet alle Seiten, Links, Überschriften, Statuscodes etc. auf. Damit identifiziert man technische SEO-Probleme wie fehlerhafte Links, fehlende Titel, doppelte Inhalte und vieles mehr. Was hat das mit der GSC zu tun? – Sehr viel, wenn man beide kombiniert!

Screaming Frog lässt sich nämlich per API mit der Google Search Console verbinden. Das bedeutet, SF kann während des Crawlings Daten aus Deiner GSC abrufen und in seinen Report integrieren. Dadurch erhältst Du einen ganzheitlichen Blick auf Deine Website: Du siehst nicht nur die technischen Details aus dem Crawl, sondern daneben z.B. die Klickzahlen oder Indexierungsstatus aus der GSC. Die Kombination dieser Instrumente liefert ein detailliertes Bild der Leistung Deiner Website – viel umfassender, als wenn Du nur eines der Tools isoliert nutzt.

Ein besonders praktischer Anwendungsfall ist das Aufspüren von Waisen-Seiten (Orphan Pages). Das sind Seiten, die nicht intern verlinkt sind und daher beim normalen Crawling vielleicht übersehen würden. Google kann solche Seiten aber trotzdem kennen, etwa durch die Sitemap oder externe Links – sie erscheinen dann in der Search Console (z.B. mit Impressionen), obwohl sie im Screaming Frog Crawl zunächst nicht auftauchen. Wenn Du SF mit der GSC-API verknüpfst, kann SF auch URLs aus GSC-Daten in den Crawl einbeziehen. So findest Du Seiten, die in GSC gelistet sind, aber keine eingehenden internen Links haben. Diese Seiten solltest Du dann intern besser vernetzen, damit sie im Website-Kontext eingebunden sind und von Nutzern (und Crawlern) einfacher gefunden werden.

Weitere Vorteile der GSC-SF-Verknüpfung: Du kannst während eines Crawls Indexierungsinformationen abrufen (via URL Inspection API bis zu 2.000 URLs am Tag) – so siehst Du bei jeder gecrawlten URL direkt, ob Google sie indexiert hat oder ob es Probleme gab. Zudem kannst Du GSC-Performance-Daten (Klicks, Impressionen) neben technischen Daten sehen. Beispiel: Du entdeckst im Crawl eine Seite mit fehlendem Title-Tag und siehst dank GSC-Daten, dass diese Seite trotzdem 500 Impressionen und 20 Klicks hatte letzten Monat. Das ist ein starkes Signal, dass Du hier schnell den Title nachbessern solltest, da die Seite Traffic-Potential hat. Natürlich ist die Integration von Screaming Frog kein Muss für jeden SEO-Anfänger. Es handelt sich eher um einen Bonus-Tipp, wenn Du Dich nach den ersten Gehversuchen mit GSC weiterentwickeln willst. Screaming Frog selbst erfordert etwas Einarbeitung, und die API-Verbindung setzt eine lizensierte SF-Version voraus (die kostenlose Variante crawlt nur bis 500 URLs und hat eingeschränkte API-Möglichkeiten). Doch es lohnt sich: Durch die Kombination von Search Console und Crawling eröffnen sich Dir tiefere Einblicke. GSC zeigt Dir was passiert (z.B. welche Seiten wenig Klicks bekommen), Screaming Frog hilft Dir herauszufinden warum (vielleicht langsame Ladezeit, fehlende Keywords, falsche Verlinkung). Zusammen kannst Du noch gezielter an Optimierungen arbeiten.

Fazit: Unverzichtbar für nachhaltiges SEO

Die Google Search Console ist mehr als nur ein Technik-Tool – sie ist dein persönliches Kontrollzentrum für SEO-Erfolg. Für Einsteiger bietet sie klare Anleitungen und Daten, um die Website Schritt für Schritt sichtbarer zu machen: von den ersten Suchanfragen, über die Indexierung bis zur mobilen Nutzung. Für Fortgeschrittene ist sie ein Schweizer Taschenmesser, das in alle Ecken der Website Einblick gibt – sei es technisches SEO, Inhalts-Performance oder Offpage-Backlinks. Und das Beste: All diese Funktionen stehen kostenlos und direkt von Google bereit.

Mit einer strukturierten Nutzung der GSC kannst du deine SEO-Strategie datenbasiert steuern. Nutze den Leistungsbericht, um Chancen zu entdecken, die Indexierungs- und Prüf-Tools, um technische Hürden zu meistern, und die Spezialberichte, um UX und Inhalte zu veredeln. Die Motivation sollte dabei sein: Jede Erkenntnis aus der Search Console ist ein konkreter Ansatzpunkt, um deine Website zu verbessern – was letztlich zu mehr Sichtbarkeit, mehr Besuchern und mehr Erfolg führt.

Egal ob du SEO-Neuling oder erfahrener Profi bist, die Google Search Console sollte ein fester Bestandteil deines Workflows sein. Sie hält dich über den Gesundheitszustand deiner Website auf dem Laufenden, warnt vor Gefahren, zeigt Erfolge schwarz auf weiß und gibt dir die Tools an die Hand, um immer weiter zu optimieren. Mach dich mit den Funktionen vertraut, experimentiere und lasse dich von den Daten leiten – so wird die Search Console zu einem zuverlässigen Begleiter, der dich motiviert und dir hilft, das volle Potenzial deiner Website auszuschöpfen. Viel Erfolg beim Analysieren, Optimieren und Wachsen!